格闘技の勝敗を予想するGPT sを作りました。

「予想屋次郎 AI格闘技予想屋」

https://chat.openai.com/g/g-mW7uaxmcr-yu-xiang-wu-ci-lang-aige-dou-ji-yu-xiang-wu-ver0-6

⚫️今のところ使えるのはchat GPTのPlusに課金しているユーザーのみです。

なかなか面白いものができたので格闘技好きの皆さんと共有したいと思います。

現役対過去の選手もオッケーです。

使い方は

試合形式 選手2名を入力してください。

例)MMA マクレガー ボブサップ

試合形式と選手同士はスペースで開けてください。

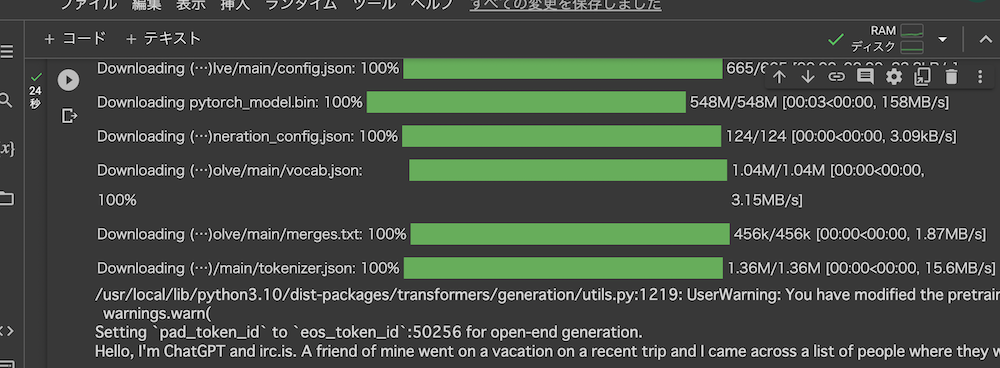

AIが情報を収集して解析するので、回答が出るまで若干時間待ちです。

過去のあの選手と今のあの選手が対戦したら。

こないだボクシングの

マイクタイソンとモハメッドアリを予想してみました。

なーるほどです。

皆さんも、ぜひお試しください。

****************

さて

格闘技って、どっちが勝つのか知りたい時がありますよね。

そんなあなたのご希望を叶えて、

2023年12月末のRIZIN 45の主要試合を予想してみましょう。

※下記の予想は全てAIのGPT-4による予想です。

当方の考えなどは一切入っていませんので、ご了承ください。

それでは、以下5試合とプラスして番外編を予想してみます。

・堀口恭司 vs. 神龍誠

・フアン・アーチュレッタ vs. 朝倉海

・クレベル・コイケ vs. 斎藤裕

・平本蓮 vs. YA-MAN

・久保優太 vs. 安保瑠輝也

番外編

・ボクシング マイク・タイソン対モハメッド・アリ

・MMAとキックボクシングでそれぞれ アントニオ猪木 大山倍達

・MMA ケラモフ対クレベル・コイケ

*********ここからGPT-4の試合予想です。

●MMA 堀口恭司 vs. 神龍誠

堀口恭司と神龍誠の試合結果について予想を行う前に、それぞれの選手のプロフィールと実績を確認しましょう。

堀口恭司のプロフィールと実績

出身地・在住地: 群馬県高崎市出身、フロリダ州ココナッツクリーク在住

生年月日: 1990年10月12日

身長・体重・リーチ: 身長165cm、体重57kg、リーチ169cm

階級: フライ級、バンタム級

スタイル: 伝統派空手(松濤館流)、オーソドックススタンス

総合格闘技戦績: 37試合、31勝(15KO/TKO、4サブミッション、12判定)、5敗(2KO/TKO、1サブミッション、2判定)、1無効試合

経歴: 第7代Bellatorバンタム級王者、初代・第4代RIZINバンタム級王者、第9代修斗世界バンタム級王者など。

神龍誠のプロフィールと実績

出身地: 宮城県仙台市

生年月日: 2000年7月5日

身長・体重・リーチ: 身長165cm、体重57kg、リーチ165.5cm

階級: フライ級

スタイル: レスリング背景

総合格闘技戦績: 19試合、16勝(4サブミッション、12判定)、1敗(判定)、1引き分け、1無効試合

経歴: 現CFFCフライ級王者、現DEEPフライ級王者、全国中学生レスリング選手権大会準優勝など。

予想分析

堀口恭司と神龍誠の間の過去の対戦では、25秒で偶発的なアイポークにより無効試合となっています。両者の戦績、スタイル、そして物理的特徴を考慮して勝敗予想を行います。

実績と経験: 堀口はBellatorバンタム級王者、RIZINバンタム級王者などのタイトルを保持し、経験豊富。一方で神龍は若干23歳であり、CFFCフライ級王者、DEEPフライ級王者などの成績を持ち、若さと勢いがある。

スタイルと能力: 堀口は伝統派空手のバックグラウンドを持ち、KO勝ちが多いことから打撃力が強いことが伺える。神龍はレスリングを背景に持ち、柔術やムエタイも経験している。

これは彼が多様な格闘技スキルを持っていることを示している。

身体的特徴に関しては、両者はほぼ同じ身長と体重であるため、物理的な優位性は特に見受けられません。

勝敗予想と勝率

堀口恭司: 経験豊富で、特に打撃において強さを持つ。国際舞台での実績も豊富。

神龍誠: 若く、レスリングを基礎に多様な技術を持つ。勢いもあるが、大舞台での経験は堀口に劣る。

勝率予想: 堀口恭司 60%、神龍誠 40%。堀口の打撃力と経験が、神龍の多様な技術と若さに対してやや優位に立つと考えられます。ただし、神龍の成長速度とポテンシャルの高さも考慮する必要があり、完全な予測は難しいです。

●MMA フアン・アーチュレッタと朝倉海

フアン・アーチュレッタと朝倉海は、バンタム級で競争する経験豊富な総合格闘家ですが、彼らの背景とスタイルはかなり異なり、それが仮想試合の結果に影響を与える可能性があります。

フアン・アーチュレッタ:

戦績: アーチュレッタのプロMMA戦績は29勝4敗です。キャリアで11のノックアウト、1のサブミッション、13の判定勝ちを達成しています。

スタイル: 彼のファイトスタイルは主にボクシングとレスリングで、ブラジリアン柔術の紫帯も持っています。この組み合わせは立ち技と地上戦の両方に対応できるスキルセットを示しています。

朝倉海:

戦績: 朝倉のプロMMA戦績は20勝4敗で、12のノックアウト勝ちと1のサブミッション勝ちが含まれます。

スタイル: 彼のバックグラウンドには空手、相撲、ブラジリアン柔術が含まれています。これは空手からの強力な打撃能力と、相撲とBJJのトレーニングからの組み技スキルを示しています。

試合分析:

打撃戦: 朝倉の空手背景は、特に速度と技術の面で打撃戦での優位性をもたらすでしょう。

アーチュレッタもボクシングの背景から優れた打撃技術を持っていますが、朝倉の多様性と速度に対応するのは難しいかもしれません。

組み技: アーチュレッタのレスリングとBJJのスキルは、組み技の交換で有利になる可能性があります。彼の地上でのコントロール能力は、朝倉の打撃能力の一部を無効にするかもしれません。

経験: 両者とも豊富な経験を持っていますが、アーチュレッタのわずかに多い試合数と、Bellator MMAやRizin Fighting Federationなどの異なるプロモーションでの経験が戦略的な優位性をもたらすかもしれません。

予想される結果:

彼らの戦績、スタイル、経験を考慮すると、フアン・アーチュレッタと朝倉海の試合は非常に競争力が高いものになるでしょう。

アーチュレッタのレスリングとBJJは彼に組み技でのコントロールを与えるかもしれませんが、朝倉の打撃は特に立ち技の交換で重大な脅威を与える可能性があります。

結果は、誰がより効果的に自分のゲームプランを実行するかに大きく依存する場合があります。

試合が主に立って行われる場合、朝倉の優れた打撃により勝利する可能性は60%ほどあるでしょう。

しかし、アーチュレッタが試合を地上に持ち込み、彼のレスリングとBJJスキルを活用できれば、彼の勝利の可能性は55%ほどに上がるかもしれません。

全体的に、試合は非常に接戦になる可能性が高く、アーチュレッタが自身の組み技ゲームをうまく実行できれば、わずかながら優位に立つと予想されます。

●クレベル・コイケと斉藤裕

クレベル・コイケと斉藤裕のMMA対戦についての勝敗予想を行います。

クレベル・コイケの特徴と戦績

生年月日: 1989年10月16日(34歳)

出身: ブラジル

身長: 178 cm

体重: 66 kg

ファイトスタイル: 柔道、ブラジリアン柔術、グラップリング、シュートボクシング

現役期間: 2008年 –

試合数: 40

勝利: 31回(ノックアウト2回、タップアウト27回)

フェザー級での活動が主。

斉藤裕の特徴と戦績

生年月日: 1987年10月8日(36歳)

出身: 日本、秋田県

身長: 173 cm

体重: 66 kg

ファイトスタイル: 伝統派空手(剛柔流)、ブラジリアン柔術(茶帯)

総合格闘技戦績: 30試合、21勝(KO 5回、一本勝ち 2回、判定勝ち 14回)、7敗、2引き分け

フェザー級での活動が主。

予想

クレベル・コイケは高いグラップリングスキルを持ち、特にブラジリアン柔術での実力が際立っています。彼の勝利の多くがタップアウトによるもので、地上戦での優位性が予想されます。

斉藤裕は空手のバックグラウンドを持ち、打撃に強みがありますが、ブラジリアン柔術でも茶帯を持つなどグラウンド戦にも一定の対応力を持っています。

ただし、クレベルと比較するとグラウンドでの技術では劣る可能性が高いです。

結論

この試合の勝敗予想は、クレベル・コイケの勝利が70%、斉藤裕の勝利が30%と見積もります。

クレベルの強力なグラップリング技術が試合を決定づける最大の要因であり、彼が地上戦をコントロールし、タップアウトに持ち込む可能性が高いと考えられます。

一方で、斉藤が立ち技で優位に立ち、打撃で試合を有利に進める可能性もありますが、クレベルの地上戦への持ち込み能力を考慮すると、その確率は低いと予想されます。

●MMA 平本蓮 vs. YA-MAN

平本蓮とYA-MANのMMA試合についての予想を行います。まずは両選手の情報を確認しましょう。

平本蓮

プロフィール: 東京出身、1998年6月27日生まれ、身長173cm、キックボクシングバックボーン。

戦歴: MMA戦績は2勝3敗。12歳で全国U-15ジュニアボクシング大会優勝、高校1年でK-1甲子園優勝、高校3年でK-1ライト級世界トーナメント準優勝、22歳で総合格闘技に転向。

スタイル: K-1で強敵を倒した打撃技術がMMAでも有効。ただし、K-1の打撃とMMAの打撃には違いがあり、MMA用の打撃に進化することでさらに強くなる可能性がある。

YA-MAN

プロフィール: 1996年5月31日生まれ、身長172cm、RIZINフェザー級で戦う格闘家。

戦績: MMA戦績は1勝0敗。

スタイル: 元キックボクサーで、オープンフィンガーグローブを使用したMMAスタイルに注目。バックボーンは野球とストリートファイト。

予想

平本蓮は打撃に優れたファイターで、K-1での経験がMMAでの打撃技術に生かされています。

一方、YA-MANも元キックボクサーとして打撃に強みを持ち、MMAでの経験は浅いものの、ポテンシャルは高いと考えられます。

平本のMMA戦績は2勝3敗とまだ安定していませんが、YA-MANのMMA経験はさらに少なく、これまでの1試合のみです。

このため、試合経験の面では平本がやや優位に立っていると言えます。しかし、両者とも打撃が得意であり、一撃で試合の流れを変える力を持っています。

勝率を予想するならば、平本蓮の勝率を約55-60%と見積もります。

これは彼の豊富な打撃経験とMMAでの成長が考慮されています。

一方でYA-MANの未知数なポテンシャルも無視できず、彼の一撃による勝利の可能性も十分に考えられます。したがって、非常に接戦となる可能性が高いです。

●MMA 久保優太 vs. 安保瑠輝也

AI格闘技予想屋

久保優太と安保瑠輝也のMMAにおける対戦を予想するため、両選手のプロフィールと戦績を詳細に分析しました。

久保優太のプロフィールと戦績:

生年月日: 1987年10月19日(36歳)

身長・体重: 175 cm, 66 kg

スタイル: テコンドー、キックボクシング

総合格闘技戦績: 3試合2勝1敗。

特記事項: RIZINでの戦いにおいて、テイクダウンやグラウンド技術の弱さが見受けられ、キックボクシングの経験が豊富でもある。

安保瑠輝也のプロフィールと戦績:

生年月日: 1995年10月29日(28歳)

身長・体重: 180 cm, 70 kg

スタイル: オーソドックス(主にキックボクシング)

総合格闘技戦績: MMAでの戦績はまだなし。

特記事項: K-1 WORLD GPスーパーライト級での活躍が顕著。しかし、MMAの経験は乏しい。

予想:

両者ともにMMAでの経験が少なく、主にキックボクシングのバックグラウンドを持つため、立ち技での戦いが中心になる可能性が高いです。

久保は総合格闘技で2勝を挙げており、一定の経験を持っていますが、グラウンド技術に課題があります。対して安保は、MMAの経験はありませんが、長身を生かしたリーチの長さと、キックボクシングでの実績が彼の強みです。

勝敗予想では、**安保瑠輝也の勝率を60%**と見積もります。この予想は、安保のリーチと立ち技のスキルが、久保のMMA経験を上回ると考えられるためです。

しかし、久保が試合を地上戦に持ち込むことができれば、彼の勝機もあり得ます。安保のMMA未経験がどのように影響するかが注目点です。

番外編

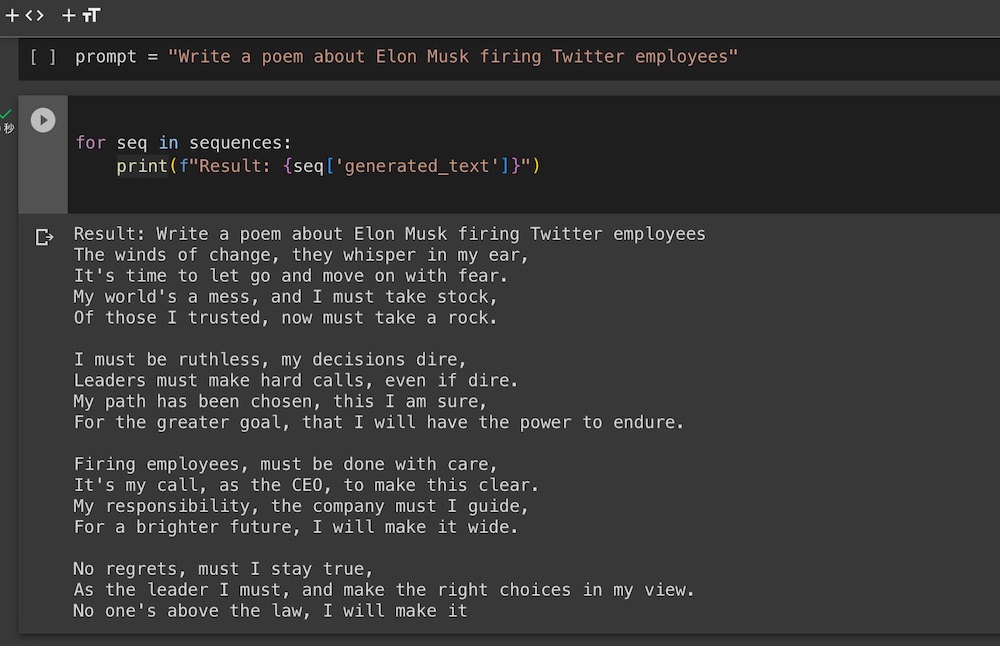

●ボクシング マイク・タイソン対モハメッド・アリ

予想するマッチアップはボクシングの試合で、マイク・タイソン対モハメッド・アリです。

マイク・タイソンの戦績は50勝6敗(58戦中、KO勝利が44回)です。彼のファイトスタイルは、ピーカブースタイルと呼ばれるインファイトスタイルで、顎を引き、軽く握った両手で顔面をガードする構えです。このスタイルでは、相手のパンチをさばきながら素早い動きで間合いをつめ、ダイナマイトパンチでKOを狙います。タイソンは右オーソドックススタイルのボクサーファイタータイプで、華やかな攻撃と凶暴なパンチを得意とし、その攻撃は左右に関わらず全てのパンチでKOを狙えるレベルです。

モハメッド・アリの戦績は56勝5敗(61戦中、KO勝利が37回)です。アリのファイトスタイルは、パワー偏重のヘビー級ボクシングにおいて革新的であり、華麗なフットワーク(「ダンシング」と形容される)と、両手を低く構えて予想外の角度から放たれる鋭い左ジャブを使う型破りなアウトボクシングでした。

これらの情報を基に、ボクシングルールでのマイク・タイソン対モハメッド・アリの試合を分析します。

タイソンの強み: インファイトでの素早い動きと強力なKOパンチ。

アリの強み: アウトボクシングでの優れたフットワークと左ジャブ。

タイソンはインファイトでの圧倒的なパワーとスピードを持ち、接近戦では非常に危険です。しかし、アリは距離を保ちながら戦う能力に優れ、相手のパンチを避けつつカウンターを狙うスタイルが特徴です。

勝率を予想すると、アリの方が若干有利と見られます。その理由は、アリの動きがタイソンの攻撃スタイルに対して効果的であり、彼のフットワークとジャブがタイソンの接近を防ぎつつポイントを稼ぐことができるからです。

ただし、タイソンが一度でも接近戦に持ち込めば、そのパワーとKO能力で試合をひっくり返す可能性があります。

予想勝率はモハメッド・アリが60%、マイク・タイソンが40%とします。

アリのフットワークとタイミングの良いカウンターが勝利の鍵となりますが、タイソンの一撃必殺のパンチには注意が必要です。

●MMA アントニオ猪木 大山倍達

アントニオ猪木と大山倍達のMMAにおける対戦予想について、現時点での情報は以下の通りです。

アントニオ猪木については、彼がプロレスラーとして新日本プロレスの創業や異種格闘技戦で活躍したことがわかりました。

彼のスタイルはスピードに満ちた正統派スタイルで、コブラツイストや卍固め、延髄斬りなどを必殺技として用いたことが記録されています。

彼は1960年に日本プロレスに入団し、リングネームをアントニオ猪木に改名した経歴があります。しかし、具体的なMMAにおける戦績の詳細については、時間の制約上、確認できませんでした。

大山倍達については、彼のバックボーンが空手道、合気道、柔道、ボクシング、朝鮮古武道(借力、テッキョン)、中国拳法であることがわかりました。

また、彼は1952年に渡米し、プロレスラーやプロボクサーと対決した経歴があります。しかし、こちらも具体的なMMAにおける戦績の詳細については確認できませんでした。

これらの情報を踏まえ、両者のMMAでの対戦予想を正確に行うためには、アントニオ猪木と大山倍達の具体的なMMA戦績やスキルセットに関するさらなる情報が必要です。残念ながら、この情報は現在のところ不足しています。

●キックボクシング アントニオ猪木 大山倍達

大山倍達に関する詳細なキックボクシングの戦績を特定することができませんでした。

しかし、彼が極真空手の創始者であることと、キックボクシングに影響を与えたことは明らかです。

アントニオ猪木に関しては、彼はプロレスラーとして活躍し、コブラツイストや卍固め、延髄斬りなどを必殺技としていました。1960年にデビューし、プロレスラーとしてのキャリアを築きました。

キックボクシングのルールでアントニオ猪木と大山倍達が対戦した場合の予想は、両者のプロレスおよび空手のバックグラウンドに基づいて行うことになります。

猪木はプロレスの技術を持ち、大山は空手の技術とキックボクシングへの影響を持っています。

キックボクシングでは、打撃技術が重要であり、猪木のプロレス技術は直接的には有効ではない可能性があります。

一方で、大山の空手のバックグラウンドはキックボクシングの戦い方に適していると考えられます。

そのため、キックボクシングのルールに基づいて予想すると、大山倍達が有利と考えられます。

勝率を予想すると、大山倍達が70%、アントニオ猪木が30%とします。

これは大山の打撃技術とキックボクシングへの影響が、キックボクシングのルールにおいて猪木のプロレス技術よりも有利であると考えられるためです。

ただし、予想はあくまで仮定に基づいたものであり、実際の試合では様々な要因が影響する可能性があります。

●MMA ケラモフ 対 クレベル・コイケ

予想屋次郎 AI格闘技予想屋として、MMAの試合でヴガール・ケラモフとクレベル・コイケの対戦を分析し、勝敗を予想します。

ヴガール・ケラモフはアゼルバイジャン出身のRIZINフェザー級の選手で、バックボーンは散打とサンボです。彼の戦績は19勝5敗で、勝率は79%、フィニッシュ率は84%です。彼の対戦相手の平均戦績は7勝3敗でした。

クレベル・コイケはブラジル出身のRIZINフェザー級の選手で、バックボーンはブラジリアン柔術です。彼の戦績は31勝7敗1引き分け1NCで、勝率は81%、フィニッシュ率は93%です。彼の対戦相手の平均戦績は11勝4敗でした。

分析を踏まえ、予想は以下の通りです:

クレベル・コイケはブラジリアン柔術のバックボーンを持ち、高いフィニッシュ率(93%)を誇ります。彼の対戦相手の平均戦績が高い(11勝4敗)ことも、彼の技術の高さを示しています。

ケラモフのバックボーンは散打とサンボで、打撃と投げ技に強みがありますが、対戦相手の平均戦績がコイケより低い(7勝3敗)ことが、若干の不利を意味するかもしれません。

勝敗の予想:クレベル・コイケの勝率を60%、ヴガール・ケラモフの勝率を40%と予想します。

コイケの柔術の技術と対戦相手のレベルの高さが、この対戦において彼に有利に働くと考えられます。

ただし、ケラモフも散打とサンボのバックボーンがあり、予期せぬ一撃で試合の流れを変える可能性もあります。

*********GPT-4の予想ここまで

さて、楽しんで頂けたでしょうか。

もっと他にも実現したい試合って結構ありますよね。

過去のあの人と今のあの人が試合したら、どうなるんだろうって。

今回もプロレスのアントニオ猪木と空手の大御所、大山先生の試合を予想してもらいました。

また、追加でいい試合が出たら、第二弾でお知らせいたします。