目次

********

※LINE対応チャットボット版の

「LINEチャットボット屋」

いろんなチャットボットがあります。

ぜひ、ご覧ください!

***************

***************

下記の記事に興味を持ったので、いろいろ調べてgoogle colabでライト実験してみました。

https://deepmind.google/blog/gemma-scope-2-helping-the-ai-safety-community-deepen-understanding-of-complex-language-model-behavior/

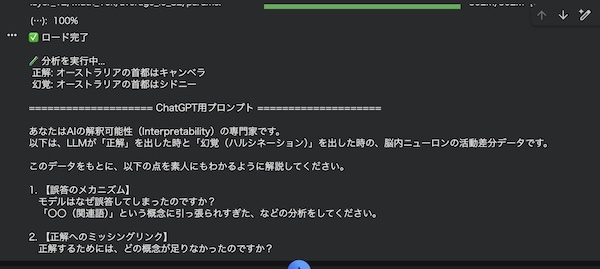

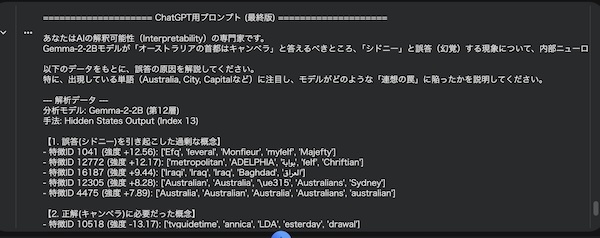

・対象モデル:Gemma-2-2B

・解析手法:Gemma Scope 2(SAE による内部特徴解析)

・観測箇所:第12層の内部特徴(正解時 vs 誤答時の差分)

・使用環境 : google colab (T4使用)

・プロンプト出力でGPT5.2で解析

・実験内容:

正解「キャンベラ」

誤答(幻覚 ハルシネーション)「シドニー」

Australia / Sydney 系特徴の過剰活性

首都=行政(office)系特徴の不足

Google DeepMindのgemma scope2とは

Google DeepMind が公開しているGemma Scope 2(gemma scope2)は、LLM(大規模言語モデル)の「頭の中で何が起きているか」を調べるための解析手法・ツール群です。

LLMは、文章をそれっぽく作るのは得意ですが、「なぜその答えを出したのか」は普通は見えません。

gemma scope2 では、

モデル内部にある大量のニューロンの活動を、意味のある特徴(feature)として整理し、

どの概念が強く働いたのか

どの概念が弱かったのか

を比較できるようにします。

これにより、AIが正解した理由だけでなく、AIが幻覚(ハルシネーション)を起こした理由も、「考え方のズレ」として説明できるようになります。

この記事では、この gemma scope2 を使った解析結果をもとに、AIがこちらの指定した「オーストラリアの首都」を間違えた理由を見ていきます。

AIはなぜ簡単な問題を間違えたのか

「オーストラリアの首都は?」

これは学校の地理でも出てくる基本問題です。

正解はキャンベラ。

ところが、LLMが「シドニー」と答えてしまうことがあります。

この現象は一見すると、「AIがバカなミスをした」「知識がない」と思われがちです。

もちろん今回の実験に使ったGemma-2-2Bは比較的小さなモデルなので、若干のミスは出るかと思います。

しかし実際には、知識は持っているのに、考え方の順番を間違えたというケースがほとんどです。

今回の解析は、そのことをとても分かりやすく示しています。

今回起きたAIの間違いを整理しよう

まず、事実関係を整理します。

問題:オーストラリアの首都は?

正解:キャンベラ

誤答(幻覚):シドニー

ここで重要なのは、シドニーが「完全なデタラメ」ではない点です。

シドニーはオーストラリア最大級の都市で、世界的にもよく知られています。

つまりこの誤答は、それなりに筋が通った方向にズレているのです。

この「もっともらしいズレ」こそが、LLMの幻覚(ハルシネーション)の特徴です。

AIの頭の中をのぞいてみる

gemma scope2 では、AIの内部で活動しているニューロンを、「特徴(feature)」という単位で観察します。

特徴とは、「国っぽさ」「都市っぽさ」「行政っぽさ」など、意味のかたまりを感じ取る反応だと考えてください。

今回の解析では、

正解したとき(キャンベラ)

誤答したとき(シドニー)

で、どの特徴が強くなったか/弱くなったかを比較しました。

なぜ「シドニー」が思い浮かんでしまったのか

誤答時に特に強くなっていたのが、次の特徴です。

Australia / Australian / Sydney

Australia / Australian

これは、「オーストラリア」という入力を受けた瞬間に、オーストラリアを代表する有名都市のイメージが一気に立ち上がったことを意味します。

モデル内部では、次のような流れが起きやすくなります。

オーストラリア

→ オーストラリアといえば?

→ 有名な都市

→ シドニー

ここで、本来必要な「首都を答える」という判断が後回しになります。

つまり、論理問題が連想ゲームに引っ張られた状態です。

本来、考えるべきだったこと

正解するために必要だったのは、「首都とは何か」という視点です。

首都とは、

政治の中心

行政機関が集まる場所

という役割を持っています。

解析では、office / workplace といった行政・公的機能を表す特徴が弱くなっていました。

本来あるべき思考の流れは、こうです。

オーストラリア

→ 首都(政治・行政の中心)

→ 政府・官庁

→ キャンベラ

しかし誤答時は、この「役割のルート」が弱く、「有名都市ルート」が勝ってしまいました。

このAIの間違いは「嘘」なのか?

この点はとても大切です。

今回の誤答は、AIが「嘘をついた」わけではありません。

AIは、

首都がキャンベラだという知識

オーストラリアとシドニーの強い関連性

その両方を持っています。

ただし、どちらを優先するかの判断で、関連性の方が勝ってしまった。

その結果、「一番それっぽい答え」としてシドニーを選んだ、というだけです。

人間の考え方ととてもよく似ている

これは人間にもよくあるミスです。

クイズで焦ると、「日本の都市といえば?」と聞かれていないのに、勢いで東京と答えてしまうような感覚です。

考え直せば分かるのに、最初に浮かんだ答えを止められない。

LLMの幻覚(ハルシネーション)は、こうした人間的な思い込みの近道ととてもよく似ています。

この分析からわかる大切なこと

今回の gemma scope2 による解析から、次のことが分かります。

幻覚(ハルシネーション)はランダムではない

概念の強弱で説明できる

「何が強すぎたか」「何が弱すぎたか」が重要

このケースでは、

強すぎた:オーストラリア → シドニー

弱すぎた:首都=行政機能

このバランスの崩れが、誤答を生みました。

まとめ AIの幻覚(ハルシネーション)を正しく理解しよう

「シドニー幻覚(ハルシネーション)」は、知識不足による失敗ではありません。

起きたのは、概念の優先順位の逆転です。

首都を考えるべき場面で、「有名な都市」という連想が勝ってしまった。

gemma scope2 のような解釈可能性の手法を使えば、このズレを具体的に説明できます。

AIの幻覚(ハルシネーション)は、怖いものでも、魔法でもありません。

理解できる現象であり、理解できるからこそ、減らし方・付き合い方を考えることができます。

「AIも人間と同じような思考ミスをする」

という点を押さえておくと、AIがより身近に感じられるでしょう。

****************

最近のデジタルアート作品を掲載!

X 旧ツイッターもやってます。

https://x.com/ison1232

インスタグラムはこちら

https://www.instagram.com/nanahati555/

***************