トップページはこちら。

DesignOffice Macs デザインオフィス マックス

***********************************

こんにちは、イソさんです。

さて、今回のテーマは「起業のメリット・デメリット」です。

起業時にはそれぞれのメリットもあり、デメリットもあります。

前編ではメリットに、後編ではデメリットにフォーカスしていきます。

まずはメリット編をどうぞ。

起業すると、経営者目線で見れるようになる

まず第一に上げられるのが、「経営者目線で見れるようになる」でしょう。

物事というのは表と裏があったり、ある方向から見たら、別の方向からも見ることができるという表裏一体感があります。

ビジネスも然りで、勤めた側から見る目線と経営者側から見る目線とがあります。

起業すると全ての目線が経営者側からのものになります。

例えば勤めている方が飲食店に入る場合、おいしい料理を食べて、いいお酒を飲んで、楽しければ終わりですね。

ところが、起業して経営者側の人間になると、同じ条件でも店に行った時に、入り口の入りやすさ、床の素材、内装、料理の質と味、飲み物のクオリティーなど、どうすればそのお店が流行るのかの目線で飲食するようになります。

まあ、わざわざノートに取ったり、ジロジロと店内を眺めるなどはしませんが、感覚的に上記を踏まえた上で、飲食しているものです。

無意識レベルといいましょうか。頭の中に自然とインプットされていくのです。

店員さんの態度ひとつとっても、勤めている時は好感の持てるいい人だなあで終わってしまいますが、経営者目線だと、あの店員さんがウチにいてくれたらなあとか、あの仕事ぶりをウチでもやってみようとかのレベルで見るようになります。

いいかわるいかは別にして、そういう目線で見れるようになるのは、ビジネスや商売をやる上では非常に利点になります。

この感覚の備わった人が使われる立場になった時には、戦力増大です。

経営者目線で見れるので、店内の全てに注意が行き届きます。

実際にこの方が経営者目線で見て気づいたことを実行するかは別です。中にはわかってても実行しない人もいるでしょう。

忙しいとか、俺の仕事ではないとか、理由はいろいろあります。

しかし、気づいているのと何もわからないとでは、別次元のお話になります。

経営者からすると、その位の事はわかってくれよという場面は多々あるものです。

勤めている側は、そこには気が向かず、目先の利益のみを追求しだすものです。

「早く仕事終わらんかなあ」とか「こんな仕事やってられんよなあ」など、ネガティブ要素を数え上げたらキリがありません。

しかし、経営者目線で見ることができる人の場合は、こうすれば売り上げが上がるよなあとか、もっとここを改善するとコストカットできるよなあとか、売り上げや粗利を増やす方法を考えて行動できます。

そういった意味でもこの「経営者感覚が身につく」というのは、起業の最大のメリットだと思います。

起業すると、仕事の利益を自分の判断で使える

勤めていると自分でやった仕事の利益でも、まずは会社が徴収し、そこから給与という形でもらう形式になります。

歩合にもよりますが、数千万単位、億単位の仕事を成立させても、もらえるのは基本的には給与の範囲内になるでしょう。

一方、起業するとこれらの大きな仕事の成果は、自分を中心にして動いていきます。

経費として何かに投資するもよし、売り上げの粗利を会社に備蓄するのもよし。

全てはあなたが判断できます。

もちろん何に使ったとか、どこに蓄えたかとかは、事細かく帳簿に付けないといけませんが、あなたの判断で会社の備品を揃えたり、投資したりできるのはメリットですね。

個人事業か法人かによっても違いますが、お金の流れは勤めている時の何倍も注意しないといけません。

特に法人の場合は、会社のお金と個人のお金は厳格に区別しないとです。

儲けは全部自分のものではない。会社という法人格がいるってことを肝に命じておきましょう。

その上で、ご自分の判断で社内のお金を動かせるのは、起業の大きなメリットです。

起業すると、簡単な経理などの知識が身につく

その次のメリットと言えば、「簡単な経理などの知識が身につく」でしょう。

これは大手の会社にいるとなかなか難しいですが、小さい会社を経営すると、会社運営の全てに目を光らせるようになります。

すると経理などのお金の出入りにも気を配るようになるので、結果として経理の用語や知識が自然と身につくようになります。

そこで、ある程度の知識を得て、その内容が楽しいと思えるのなら、経理の専門家になる方法もあるでしょう。

やってみないとわからない分野というのは結構あるものです。やらず嫌いとでもいいましょうか。

しかし、イヤイヤでもやっていくうちに知識がついて、自然と好きになることは多いです。

心理学でも実証されていることですが、嫌いなことを克服するのには、その嫌いな事を勉強すればいいという理論があります。

勉強してその事に関する知識がついてくると、「人はその事を好きになる」ようなんですね。

詳しくは論文などで調べて欲しいのですが、私の経験上でもこの事は間違いないと思います。

知ってくると面白くなる。面白いからさらに掘り下げる。するとますます好きになると。

仕事の嫌いな人でも、いざ自分が独立して商売をしていると、自然とその商売が好きになってくるものです。

今、前向きに仕事に取り組めない人もいると思いますが、そんな人は独立して自分で始めてしまうのも手です。

やっていくうちに好きになるかと思います。

プラスして経理の知識も身につけば、1石なんちゃらですよね。

起業すると、仕事が楽しくなる

前段からの続きっぽいですが、起業すると勤めている時と同じことをやっても、仕事が楽しくなります。

勤めている時には、あんなにイヤだと思ってやっていた仕事が楽しくなるから不思議です。

理由はいくつか考えられます。

まず一つは、独立起業しての仕事というのは、ある程度自分の裁量で受託できるからです。

言い変えると、やりたくない仕事は受けなくていい。これが可能になるのです。

勤めているとやりたくない仕事を上司にまかせられる事が多々あると思います。

起業していると、このやりたくない仕事は断れるんですね。

もちろん、断るとお金になりませんが、やりたくないのだから仕方がないと割り切れるようになります。

もっと他の事で稼げるからいいやと、自分に納得させることができるのです。

これは、もしかしたら最大のメリットかも知れません。自分のやりたい仕事だけを選択できるという。

メンタル的には非常にいいですね。効率も上がります。だってやりたくて自分で選んだ仕事ですから。

最悪、お金の問題でやりたくない仕事を請けてしまった場合でも、外注に出せば済むのです。

今の時代、アウトソーシングでやりたい方は、探せば結構いるものです。

一部を自分でやって残りを外注に出すとか、いろいろ選択肢があるのが起業のメリットです。

起業すると、人間の器が大きくなる

そんなバカなという方もいるでしょうが、これは事実です。

これも心理学の実験で実証されているのですが、人は置かれている立場で、その人の器量に影響が出てくるものです。

経営者、社長、代表という地位になると、自然とそのような態度になり、周りに目が届き、人からの人望も厚くなるなど、リーダーとしての資質が身についてきます。

「地位が人を作る」という言葉を聞いたことがあると思いますが、これは間違いない事実です。

態度が落ち着く、堂々とするなど、器がでかくなります。

まあ、ある意味若くてそうなると謙虚さがないなどと言われることもありますが、仕方ありません。

年齢が追いついてくるまでの辛抱です。

また、周りの人間も経営者にはそのような態度で接してくるので、大企業でなかなか上の地位にいくのが難しい人も、独立してトップに立ってしまえば、内面から変われます。

人間というのは意外と単純なものなのです。

ただ、逆にそれまで経営者だった人が、失墜してどん底に落ちると、態度や内面的な心の状態も小さい人間になってしまう場合があります。

これも仕方がありません。

しかし、そこは心を振り絞って、再度立ち上がってチャレンジしましょう。

チャレンジ精神を失わなければ、たまたま今は低い所にいるだけで、すぐにまた這い上がれると自分に言い聞かせて、以前の器を維持できます。

ネバーギブアップです。決して諦めない。勝負は諦めない限り続いているのですから。

商売・ビジネスがどのように動いているのかを知ることができる

起業すると、商売・ビジネスの全体的な動きというのがわかってきます。

お金を投資して、その元金で道具や人を雇い、商品を仕入れて、加工して販売する。

あるいはサービス業なら、サービスという付加価値を付けて、人様に利用してもらう。

細かい資金の動きや、粗利、会社の儲け、支払いなど、企業に勤めていると、こういった項目の一部しか担当できませんが、起業するとそれら全般が目に入ってきます。

まあ、中には細かいことは社員に任せて、営業のみに邁進するとか、技術製作だけを集中してやる起業家もいるでしょう。

しかし、その気になれば、上記の流れの全てを見て、論じることができるようになります。

この点も大きいですね。大企業では味わえない感覚を養ってください。

起業前に、これらの一部を得る方法

こういった感覚の一部を会社に勤めながら得る方法があります。

小さいベンチャー企業で働いてみることです。

できれば、創業間もない、社長の近い所にいるのがベストです。

すると、会社のお金の流れや動き、社長がどのように考えて行動しているのかとか、ざっくりとですが、経営者の身近にいることで流れが見えてきます。

自分で独立するとリスクも背負わなければいけませんが、この方法ならリスクなしで、経営者に近い感覚を養えます。

完全ではないです。あくまでもざっくりとです。

真実の経営者感覚は実際に起業しないとわからないです。

しかし、これから起業を視野に入れている方で、一部でも先に学びたいって人には、勉強になる方法です。

起業のメリットのまとめです

こうしてみると起業というのは、メリットが結構あると思います。

内面的なものが多いですが、自分自身を成長させるには起業は手っ取り早い方法です。

次の記事では、反対にデメリットを書いていきますが、起業においてはメリットの享受は結構大きいです。

まずは実行。走りながら考え、修正し、また走ると。

やりながら考えましょう。

起業のデメリット

今度は起業のデメリットを上げてみましょう。

まずは、こちら。

資金がみるみる減っていく

これは起業した方なら痛感しているでしょう。最初に投下した資金の目減りが早いこと早いこと。

初期投資はその商売の設備などにも使われるので、一気に大金が減っていきます。

なるべく資金がかからないように工夫をしていても、知らず知らずのうちに軍資金が減っていきます。

最悪、資金ショートとかにならないように、常に資金とはにらめっこをしながら、商売を続けなければいけません。

この時に日銭の入る商売は有利です。例えば飲食店とか、販売系のお店など。

現金でお客様が買ってくれる商売は、昨日お金がなくても、今日には入ってくるというメリットがあります。

今日の糊口はしのげるのです。

これが売掛金が多い商売だと、なかなか辛くなります。売り上げが上がって黒字になっても、資金が追いついていかない。

数ヶ月待たないと入金されない。しかし、支払いは済まさないといけない。

キャッシュフローをある程度キープしておかないと、黒字倒産のリスクがある。

日銭商売を羨ましく感じる瞬間ですね。

なので、リスク分散でこういった掛売り商売は、日銭商売を副業におくのも手です。

本業でお金が入ってこなくても、日銭でしのぐと。

うまいこといけば、副業が本業をしのぐ日も来ないとは限りません。

特に飲食は大化けする可能性もあります。

ここら辺は以前の記事も参照してください。

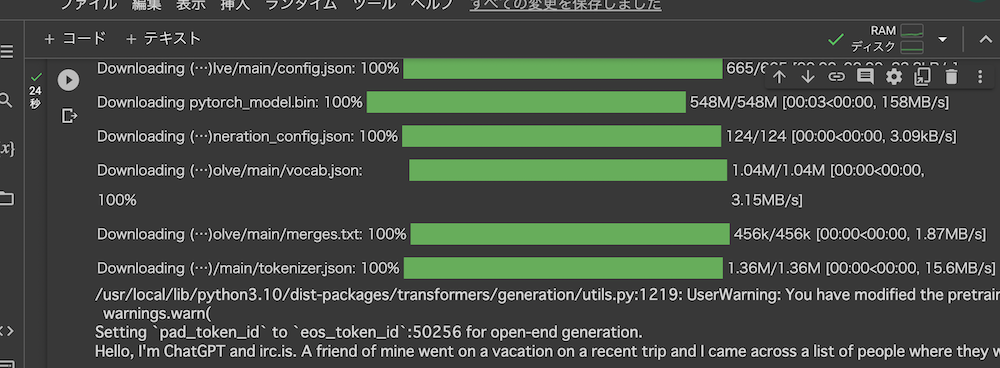

余計な事務作業が増える

起業すると個人事業であろうが、会社であろうが、税金をご自分で申告して納めないといけません。

今までは会社でやってくれた諸々の事務作業を自分ですることになります。

これをデメリットかどうかはさておき、面倒な作業が増えるのは間違いないです。

日々の売り上げや使った経費の領収書などは保管しておき、帳簿を付けて、年に1回は申告するのです。

これらの作業を全て税理士さんにお願いするところもあるでしょうが、起業したてのベンチャーは経費削減のために、社長みずから帳簿を付けるなんてのはざらにあります。

今は会計ソフトで結構いいものが揃っているので、きちんと帳簿を付けていれば、申告書はソフトが自動で出力してくれます。

なので、日々の出入金の帳簿付けをしっかりとやっておく。これに尽きます。

売り上げが小さいと、お金の出入りもあまりないので、帳簿付けも楽です。

売り上げが上がって、ご自分で帳簿付けなどができなくなった際には、人を頼み、代わりにやってもらうと。

ここら辺はあまり心配なさらなくても大丈夫です。

それよりも、いかに売り上げを上げていくかの方に目を向けましょう。

収入が安定しない

起業すると会社に勤めていた時のように給与が安定しなくなります。

最悪、収入なしの月も当初はあるかと思います。

売り上げの絶対法則はありませんので、集客できないとか、売り上げがあっても焦げ付いたとかで、収入は安定しない可能性があることを忘れてはいけません。

飲食店のように日銭が入る場合は、さほどその日の食い扶持には困りませんが、掛売りの商売だと、入金までに手持ち資金なしで、食べるのは大変てことも絶対ないとは言えません。

軌道にのるまでの運転資金は、ある程度用意して起業に入った方がよろしい場合があります。

独身で実家暮らしとかなら、起業で売り上げが上がらなくても食べてはいけます。

しかし家族を養っていたり、ローンを背負い込んでいたりすると、資金の調整をうまくしないとです。

先月より数万円収入が減るなんてのはざらにあります。

起業してからの「収入の安定」はないと思った方がよいでしょう。

ただ裏を返せば、利益も無限大です。

大きな仕事をした時の儲けの大部分を自分と会社で独占できます。

ギャンブルのようですが、起業とはそんなものです。

倒産した時に借金を背負う場合がある

起業してうまくいけば問題ありませんが、仮に失敗して借金をした場合には、多額の負債を負う場合があります。

最初の資本金にプラスしていくらの借り入れをしたかによりますが、借り入れが多額だったり、事業途中でも大きな借金をした場合、リスクが大きいですね。

初期投資の大きいビジネスや在庫を大量に抱えないといけないビジネスほど、そのリスクが大きいです。

一方、ソフトウエア系やITサービス系などの在庫をあまり抱えない商売は、人件費さえしっかり押さえておけば、多額の負債は負わないで済みます。

とは言っても、最新ゲーム開発などの人件費莫大ビジネスになると、製作中は一切キャッシュが入ってきませんから、リリースしてからの失敗は資金ショートになる可能性が大きいです。

一発当たれば大きいので、夢をかける開発業者が多いのもこの世界の特徴です。

なるべく、大きな借金をしないでの経営が望ましいのですが。

起業時の人間関係がこわれることがある

起業時にあれほど仲のよかったメンバーとも、徐々に仲がわるくなる場合があります。

これは商売が成功しつつあっても、逆に失敗しつつあってもです。

商売が成功しつつあると、新しい人を雇わないといけなくなります。

総じて、創業メンバーというものは、トップの人を除くと、普通の人が多いものです。

それは仕方ありません。わけのわからないベンチャーっぽい会社や個人事業に参加する人に、超優秀な人がいるとは思えません。

超優秀な人は大きい会社や自分を高く買ってくれる所を選びたがります。

わけのわからんベンチャーっぽい所は、普通の人でないと来てくれないのです。

しかし、商売が成功して新しい人を雇い始めると、創業メンバーより優秀な人が集まってきます。

すると、古参の創業メンバーは取締役や事業の中核を占めていることが多いので、その新しい優秀な人との力のアンバランスさが軋轢(あつれき)を生むのです。

普通の人が中核にいる所に優秀な人が仕えるのは、上に立つ人が苦労します。

また、使われている側も不満を抱きます。

特に優秀な人ほどプライドが高いので、普通の人に使われるのを嫌がる傾向にあります。

すると社内に不満の嵐が吹き荒れます。

その不満はトップにいくことが多いです。

なぜ事業を拡大するのかと。今のままでうまくやっていけばいいのではと。

古参メンバーの不満がトップに向かいます。

結果はわかりますね。古参メンバーの大量離脱というものが急成長した会社には多いのです。

反対に商売が失敗しつつある時も同じような現象がおきます。

そもそも資金が枯渇し始めると、社内の空気はわるくなります。

誰もが自分の給与は保証してほしいものですが、大丈夫かいなと。

早めに手を打つ人が出てくるのも仕方ありません。

このように、どちらにしろ、起業時の人間関係はこわれていくことが多いのがデメリットの一つでしょう。

(※もちろん起業時のメンバーとうまくやっている所も多いです。あくまでも一例です)

起業のデメリットのまとめ

整理して書いていると、起業時のデメリットは資金面に関することが多いですね。

起業に失敗しても、大きな借金を作らなければ再起可能です。

デメリットよりも冒頭で書いたメリットの方が大きいのが起業です。

多額の借金はしんどいですが、なるべく手持ち資金で。

借り入れをしても最小限で。

その事を肝に銘じしつつ、起業にチャレンジしていきましょう。

***************

ホームページ・webからの集客ならお任せ。

お問い合わせは

SEO対策 ホームページ制作 YouTube動画なら埼玉県熊谷市のデザインオフィス マックス

TEL 048-580-3253